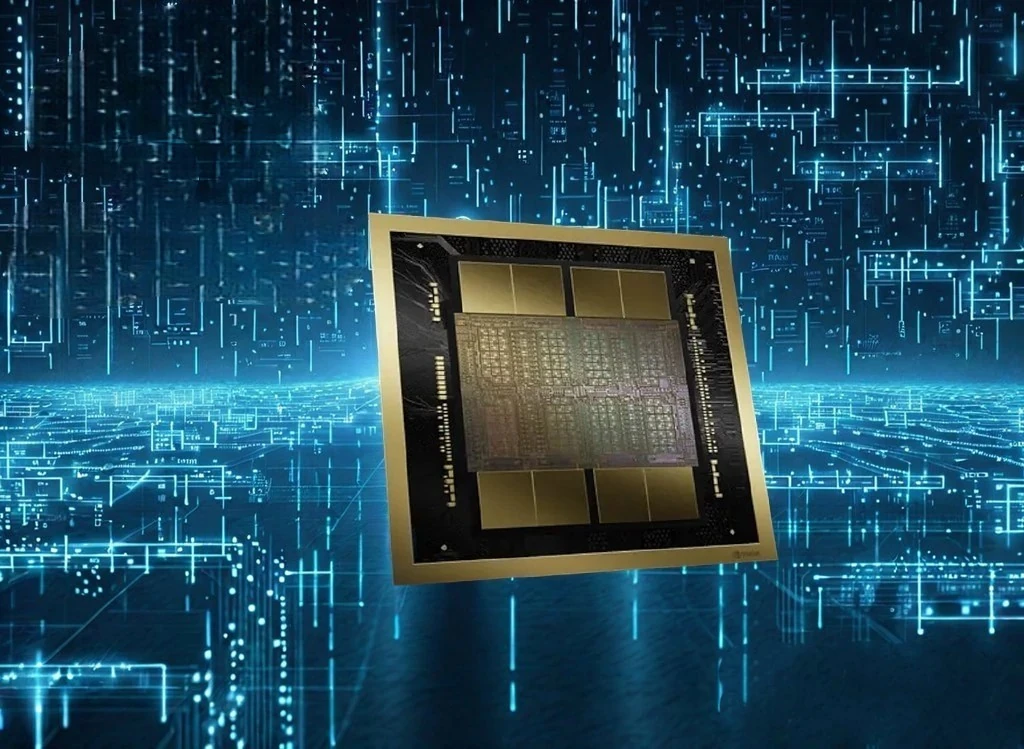

A Nvidia acaba de lançar seu novo chip principal de IA, o B200, também conhecido como Blackwell B200. O anúncio foi feito em 18 de março de 2024, na GPU Technology Conference (GTC) anual da empresa.

O chip B200 foi projetado para oferecer recursos de IA de alto desempenho e deverá ser lançado ainda este ano. O contexto do chip B200 AI da Nvidia é que ele é o mais recente produto principal de IA da empresa, parte da plataforma Blackwell, e foi projetado para melhorar significativamente o desempenho da IA. O chip B200, baseado na arquitetura Blackwell, é um poderoso chip GPU especializado em tarefas de IA, ostentando 208 bilhões de transistores e oferecendo melhorias substanciais de desempenho em relação a seus antecessores, como o H100. A Nvidia pretende ampliar seu domínio na indústria de IA com este novo chip, que é 30 vezes mais rápido em determinadas tarefas, como fornecer respostas de chatbots. O chip B200 faz parte de um ecossistema que inclui tecnologia proprietária de interconexão, permitindo à Nvidia vender seus chips em grandes clusters que funcionam como um processador unificado. Este chip é destinado a empresas e não a indivíduos, com grandes players de tecnologia como Amazon Web Services, Google, Microsoft, Meta e outros confirmados para adotá-lo em seus serviços de computação em nuvem. Além disso, o chip B200 estará disponível na placa de servidor HGX B200, conectando oito GPUs B200 através do NVLink para suportar plataformas de IA generativa baseadas em x86.

Desempenho sobrealimentado:

- Potência do transistor: Com impressionantes 208 bilhões de transistores, o B200 possui mais que o dobro da capacidade de processamento em comparação com seu antecessor. Isso se traduz em ganhos significativos de desempenho em tarefas como treinamento de modelos de IA, permitindo aos pesquisadores criar aplicações ainda mais complexas e poderosas.

- Speed Demon: O B200 supostamente oferece até cinco vezes mais desempenho geral, tornando as tarefas de IA significativamente mais rápidas. Em áreas específicas, como treinar grandes modelos de linguagem, afirma-se que é 30 vezes mais rápido. Esse impulso pode revolucionar campos como processamento de linguagem natural e desenvolvimento de chatbots.

Avanços arquitetônicos:

- Acesso à memória de alta largura de banda: O B200 possui acesso aprimorado à memória, permitindo que sua enorme contagem de transistores funcione em conjunto com mais eficiência. Isso se traduz em processamento de dados mais suave e cálculos mais rápidos.

- Design de chip duplo: Essencialmente, o B200 combina o poder de dois chips da geração anterior em uma única unidade. Este design inovador permite ganhos significativos de desempenho, mantendo um tamanho gerenciável.

Impacto geral:

- Domínio da IA: Os especialistas acreditam que o B200 solidificará a liderança da Nvidia no mercado de chips de IA. Isto poderia ter implicações significativas para o desenvolvimento e implantação de tecnologias de IA em vários setores.

- Inovação acelerada: O poder de processamento do B200 pode potencialmente acelerar os avanços na pesquisa e desenvolvimento de IA. Tempos de treinamento mais rápidos e modelos mais poderosos poderiam levar a avanços em áreas como carros autônomos, diagnósticos de saúde e computação científica.

Resumo:

Embora ainda seja cedo para avaliar completamente o impacto do B200, sua chegada está gerando entusiasmo na comunidade de IA devido ao seu desempenho impressionante e design inovador, sugerindo que este chip tem o potencial de transformar significativamente o panorama da inteligência artificial.

Lançando novo chip pra IA e depois elas fazem bom uso deles dominando a gente >.< Ótima matéria como sempre.

kkk